背景介绍

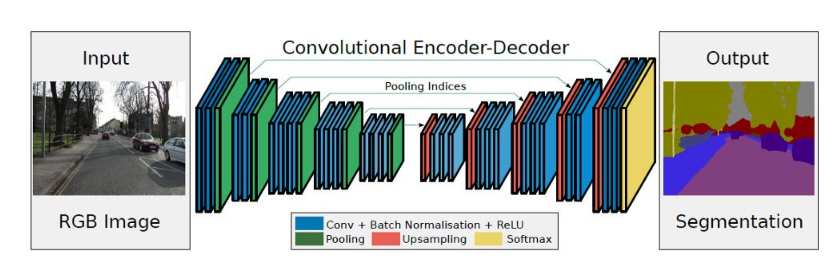

SegNet:由剑桥大学提出,2015年被提交到CVPR,但是最后没有发表,反而在2017年发表在TPAMI上。是一种简单高效的语义分割模型。

SegNet特点

网络分为两个部分,**编码(Encoder)和解码(Decoder),结构简单,网络易于实现

使用了Maxpooling-Indices(最大池化索引)**来进行图像分辨率的提高,而不是采用上采样或者反卷积。

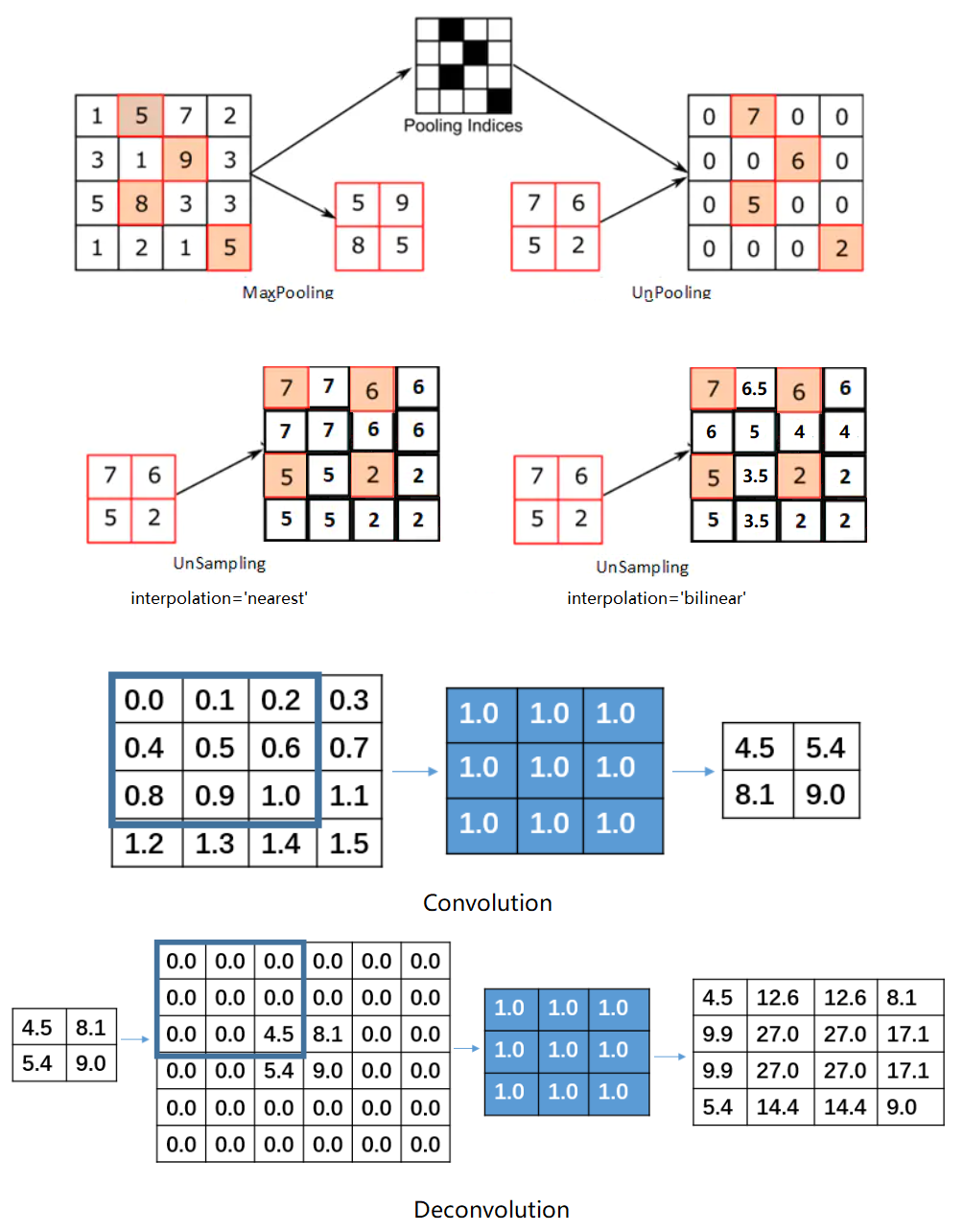

Maxpooling-Indices(最大池化索引)与Upsampling(上采样)和Deconvolution(反卷积)之间的区别

Maxpooling-Indices(最大池化索引):又称为Unpooling(反池化),池化后记录最大值所在的位置,在反池化的过程中,给相应位置上写入值,其他位置为0。这个方法没有参数,但是这个方法并不常用,因为存在大量的稀疏数据,使模型收敛速度大大降低。

Upsampling(上采样):将输入resize到设置大小,然后利用指定的插值方法对周围的值进行插值,常用最近邻插值和双线性插值。因为相邻区域的像素和特征应该是相似的,因此这个方法特别常用,既没有参数,也不会存在稀疏数据。

Deconvolution(反卷积):本质是卷积,注意反卷积并不能从卷积的结果返回到卷积前的数据,只能返回到卷积前的尺寸。卷积通过设置kernel_size卷积核大小,strides步长和padding填充方式可以将图像的分辨率降低,相反的反卷积可以通过设置kernel_size卷积核大小,strides步长和padding填充方式先对数据进行填充,然后再进行卷积操作,可以将图像的分辨率增加。**这个方法不推荐经常使用,因为存在大量参数,而且可能会存在棋盘格效应,可以参考棋盘格可视化**。

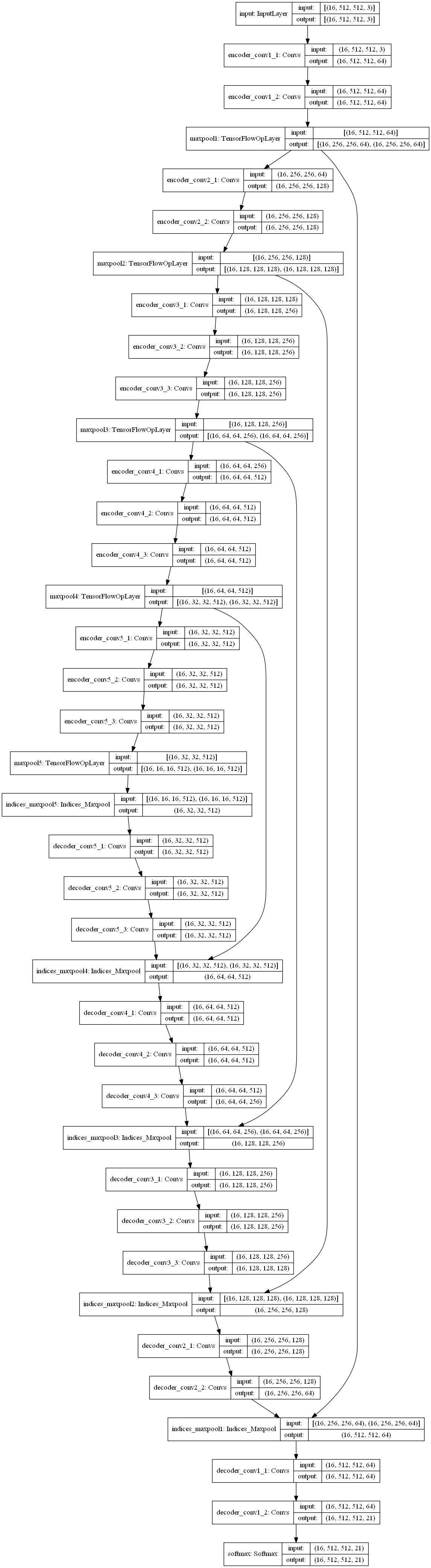

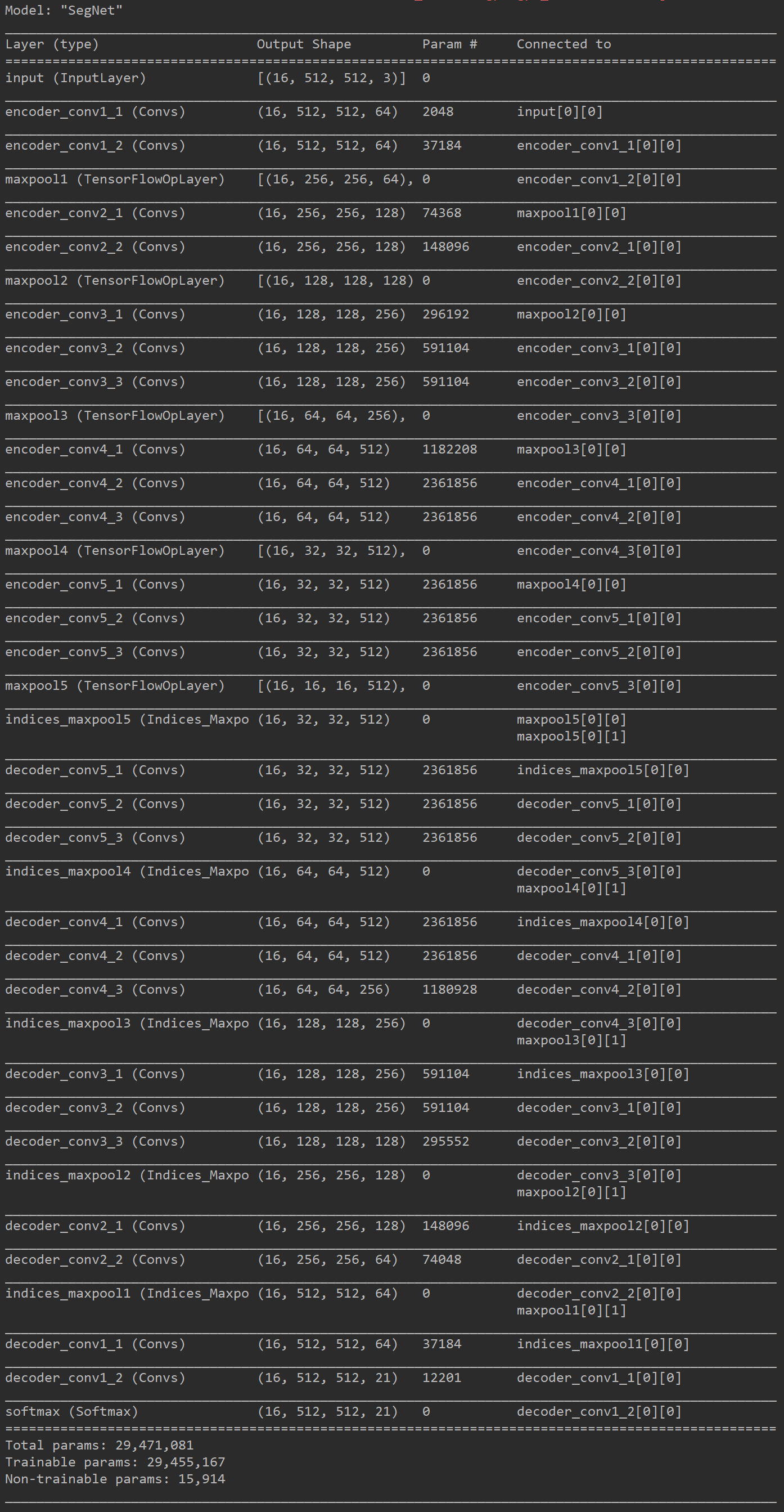

SegNet图像分析

TensorFlow2.0实现

1 | from functools import reduce |

Shape数据集完整实战

文件路径关系说明

- project

- shape

- train_imgs(训练集图像文件夹)

- train_mask(训练集掩模文件夹)

- test_imgs(测试集图像文件夹)

- SegNet_weight(模型权重文件夹)

- SegNet_test_result(测试集结果文件夹)

- SegNet.py

- shape

实战步骤说明

- 语义分割实战运行较为简单,因为它的输入的训练数据为图像,输入的标签数据也是图像,首先要对输入的标签数据进行编码,转换为类别信息,要和网络的输出维度相匹配,从(batch_size, height, width, 1)转换为(batch_size, height, width, num_class + 1),某个像素点为哪一个类别,则在该通道上置1,其余通道置0。即神经网络的输入大小为(batch_size, height, width, 3),输出大小为(batch_size, height, width, num_class + 1)。

- 设计损失函数,简单情况设置交叉熵损失函数即可达到较好效果。

- 搭建神经网络,设置合适参数,进行训练。

- 预测时,需要根据神经网络的输出进行逆向解码(编码的反过程),寻找每一个像素点,哪一个通道上值最大则归为哪一个类别,即可完成实战的过程。

小技巧

- 设置的图像类别数为实际类别数+1,1代表背景类别,此数据集为3类,最后的通道数为4,每一个通道预测一类物体。在通道方向求Softmax,并且求出最大的索引,索引为0则代表背景,索引为1则代表圆形,索引为2则代表三角形,索引为3则代表正方形。

- 最大池化收敛速度较慢,因此换成上采样,不但可以使模型更加简单,而且可以加快网络的收敛速度。

- 设置了权重的保存方式,学习率的下降方式和早停方式。

- 使用yield关键字,产生可迭代对象,不用将所有的数据都保存下来,大大节约内存。

- 其中将1000个数据,分成800个训练集,100个验证集和100个测试集,小伙伴们可以自行修改。

- 注意其中的一些维度变换和numpy,tensorflow常用操作,否则在阅读代码时可能会产生一些困难。

- SegNet的特征提取网络(编码网络)类似于VGG,小伙伴们可以参考特征提取网络部分内容,选择其他的网络进行特征提取,比较不同网络参数量,运行速度,最终结果之间的差异。

- 图像输入可以先将其归一化到0-1之间或者-1-1之间,因为网络的参数一般都比较小,所以归一化后计算方便,收敛较快。

- 实际的工程应用中,常常还需要对数据集进行大小调整和增强,在这里为了简单起见,没有进行复杂的操作,小伙伴们应用中要记得根据自己的需要,对图像进行resize或者padding,然后旋转,对比度增强,仿射运算等等操作,增加模型的鲁棒性,并且实际中的图像不一定按照顺序命名的,因此应用中也要注意图像读取的文件名。

完整实战代码

1 | import os |

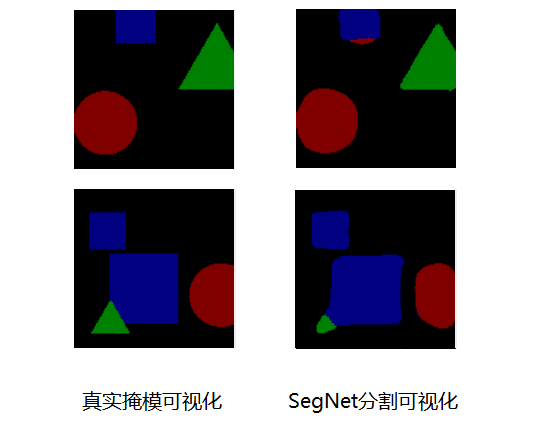

模型运行结果

SegNet小结

SegNet是一种简单的语义分割网络,从上图可以看出SegNet模型的参数量只有29M,虽然现在SegNet网络不是最好的语义分割网络,但是其编码解码结构的思想,对后面的深度学习网络的发展有重要的影响。